Les nouvelles méthodes de la désinformation prorusse

- Publié le 28 novembre 2025 à 13:06

- Mis à jour le 5 décembre 2025 à 16:27

- Lecture : 8 min

- Par : Dounia MAHIEDDINE, AFP France

Deepfakes, témoignages invérifiables, manipulations de vidéos ou encore infiltration de jeux vidéo : les désinformateurs prorusses renouvellent sans cesse l'éventail de leurs armes numériques pour affûter leurs infox. Avec un objectif qui reste le même: polariser le débat public et brouiller la frontière entre le vrai et le faux dans les pays soutenant l'Ukraine.

Depuis février 2022, cette guerre informationnelle est menée en parallèle de l'offensive militaire russe en Ukraine, en mobilisant un arsenal désormais bien rodé pour diffuser des récits pro-Kremlin: création de faux médias, de sites internet, de fondations à façade indépendante, utilisation de fermes à trolls et de centaines de milliers de faux comptes ou encore de bots automatisés.

A cette panoplie devenue classique se sont ajoutés plus récemment de nouveaux procédés.

Vidéos impossibles à authentifier

Face au travail des fact-checkeurs, les acteurs de la désinformation ont notamment affiné leurs méthodes pour compliquer l'authentification des contenus vidéos.

Pour éviter d'usurper l'identité de personnes qui pourraient porter plainte ou faire retirer rapidement les contenus où elles apparaissent, les désinformateurs privilégient désormais des visages anonymes créés par IA ou issus de banques d’images pour créer leurs deepfakes mettant en scène de prétendus lanceurs d'alerte, impossibles à retrouver.

Un exemple récent: une vidéo diffusée le 19 septembre sur X, dans laquelle une prétendue "personal shopper" (conseillère en achats de vêtements) d'Olena Zelenska aurait dévoilé une tenue d'une valeur proche d'un million d'euros appartenant prétendument à l'épouse du président ukrainien Volodymyr Zelensky. L'AFP n'a pas pu identifier la femme filmée : les recherches via les outils PimEyes et FaceCheck renvoient à une simple photo de banque d’images, et selon StopFake, la séquence repose sur un deepfake utilisant le visage d’un mannequin (lien archivé: ici).

Autre exemple: début octobre, une campagne prétendant qu'Emmanuel Macron aurait commandé un "bunker de luxe" mettait en scène un supposé ingénieur nommé "José Meier".

Ce visage avait déjà été utilisé dans une autre fausse vidéo sous le nom de "François Faivre", comme expliqué dans ce papier de l'AFP.

Des recherches ont permis de retrouver un individu aux traits similaires sur la banque d’images iStock. Le même visage apparaît également dans plusieurs contenus commerciaux sans lien entre eux (1, 2, 3, 4, 5).

Une autre méthode, plus rudimentaire mais très rapide à mettre en œuvre consiste à flouter totalement les intervenants, pour empêcher toute identification qui pourrait démontrer la tromperie.

Faire apparaître des individus au visage camouflé, livrant des révélations face caméra, est aussi une des nouvelles tendances observées : une série de vidéos relayées en 2025 ont ainsi par exemple mis en scène des témoins anonymes et masqués, prétendant appartenir à des cartels mexicains ou détenir des informations explosives, concernant notamment de prétendues ventes d'armes américaines par l'Ukraine. Là encore, aucune identification n'est possible, compliquant toute vérification de ces allégations.

Les angles morts des IA

Une partie des campagnes de désinformation cherchent désormais principalement à saturer les moteurs de recherche avec de fausses informations, en partant du principe que les chatbots considèrent une affirmation comme fiable dès lors qu'elle est abondamment disponible en ligne.

Les modèles de langage (LLM) comme ChatGPT, Gemini ou Grok étant de plus en plus utilisés pour obtenir des réponses directes à des questions, sans consultation directe des sources utilisées, les internautes deviennent ainsi de plus en plus vulnérables aux infox, estiment plusieurs experts interrogés par l’AFP.

"Les récits plus niches", portant sur des allégations non relayées par les médias et donc non réfutées quand elles sont fausses, "ont plus de chances d’être relayés par l’IA, parce qu’ils ne rencontrent pas de contre-discours structuré. Et donc, lorsqu’un chatbot tente de récupérer des informations à leur sujet, il les trouve principalement sur des sites douteux", explique Mykola Makhortykh, chercheur à l'Institut de Communication de l'Université de Berne.

Selon lui, la désinformation ciblant l’IA "n’a pas besoin d’être crédible pour un humain : il peut s’agir d’un mur de texte qui sera intégré aux données d’entraînement" des chatbots.

Un rapport de NewsGuard, une organisation qui analyse la fiabilité des sites et contenus en ligne, affirme que 33,55 % des réponses de dix chatbots testés reprennent des récits faux de désinformation prorusse. Les LLM, ces modèles de langage massifs, fonctionnent à partir de probabilités : si on augmente artificiellement la présence de récits pro-Kremlin, on augmente mécaniquement la probabilité qu’ils soient repris.

Selon Chine Labbé, rédactrice en chef de Newsguard, la multiplication des contenus dans différentes langues et formats amplifie ce phénomène : "En saturant les résultats des robots d'indexation et des recherches sur les moteurs de recherche, ils arrivent à influencer les réponses des chatbots qui font un calcul probabiliste. Si vous avez 50 articles dans 25 langues affirmant que Zelensky est corrompu, le chatbot va tendre à le répéter". "Ces contenus n'ont aucune viralité en ligne, donc ils n'existent pas pour devenir viraux", analyse-t-elle.

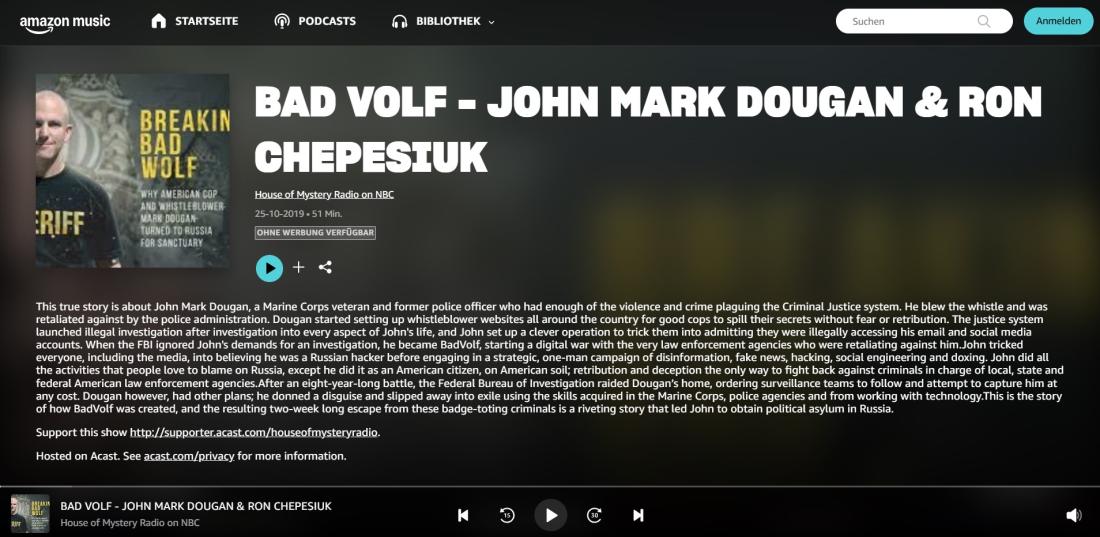

Elle évoque l'intervention d'un ancien shérif adjoint de Floride et ancien Marine exilé à Moscou, au cœur de l'opération de désinformation Storm-1516 (lien archivé: ici). Lors d’une table ronde organisée à Moscou le 27 janvier 2025, John Mark Dougan (lien archivé: ici) a fait valoir que la diversification massive des contenus amplifiait leur impact et pouvait "changer l’IA mondiale" en poussant des récits russes.

Selon lui, cette tactique permettrait non seulement d’étendre la portée de ces récits, mais aussi de corrompre les ensembles de données des modèles d'IA : "Plus ces informations sont diversifiées, plus elles ont un effet d’amplification. Non seulement cela affecte l’amplification, mais cela affecte aussi l’IA future".

Selon un autre rapport de l'Institute for Strategic Dialogue (ISD), un think tank indépendant qui mène des études sur des enjeux sécuritaires et socio-économiques, les chercheurs ont constaté que les requêtes malveillantes généraient près de trois fois plus de sources russes que les requêtes neutres. Autrement dit, lorsqu'on teste un système avec des prompts remplis de biais ou de questions malicieuses, l'outil renvoie beaucoup plus souvent vers des contenus issus d’écosystèmes russes que lorsqu’on lui soumet des requêtes plus neutres et objectives.

Pour Mykola Makhortykh, "nous allons vers une ère où l’IA empoisonne l'IA". "Et plus la frontière entre le vrai et le faux s’efface, plus il devient urgent d’agir avant qu’elle ne disparaisse complètement", prévient-il.

Jeux vidéo, streaming et plateformes jeunes

Bien qu’il soit largement identifié comme un acteur clé de la désinformation, avec la création de faux sites multilingues destinés à influencer des campagnes présidentielles en Europe et à alimenter diverses ingérences, John Mark Dougan continue de trouver des relais pour diffuser son contenu.

Plusieurs plateformes commerciales et grand public contribuent ainsi à maintenir sa visibilité, en proposant ses vidéos sur Rumble et YouTube (1,2), ses interventions en podcast sur Amazon Music, ainsi qu’un livre vendu sur Amazon. Il intervient également régulièrement dans le podcast Red Pill News (1, 2).

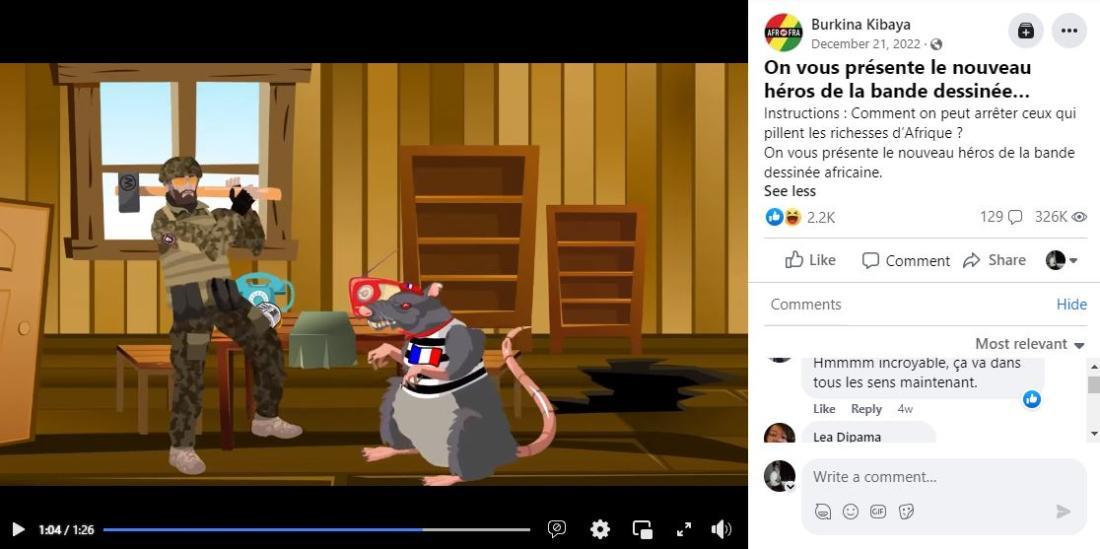

Un article publié par The Conversation (lien archivé: ici) rappelle que des réseaux liés à l’entourage d’Evgueni Prigojine, le défunt chef du groupe Wagner, avaient déjà investi le terrain du divertissement, produisant plusieurs films et séries animées.

Les jeux vidéo constituent désormais un vecteur supplémentaire de diversification des terrains d'influence : le jeu de simulation de guerre Best in Hell place ainsi le joueur dans la peau de soldats russes opérant en Ukraine et le jeu African Dawn, une version modifiée de Hearts of Iron IV lancée en 2024 et promue par African Initiative, une structure connue pour ses liens avec le Kremlin, invite les joueurs d’Afrique de l'Ouest à créer une "confédération sahélienne souveraine".

Autre vecteur d'approche des joueurs: les conversations en cours de jeu sont utilisées comme des vecteurs de diffusion de l'influence du Kremlin.

Les plateformes massivement fréquentées par un jeune public, comme Minecraft ou World of Tanks, sont également investies. Certaines cartes de Minecraft reconstituent les combats de Bakhmout ou la prise de Marioupol en Ukraine.

Pour Christine Dugoin, chercheuse en géopolitique : "On va sur des plateformes où la prévention est très faible. Les adolescents ou préadolescents ne sont pas pleinement conscients des risques". Elle décrit une dynamique d'adaptation permanente :"À chaque fois que vous mettez un bouclier, on cherche une nouvelle faille. C’est le principe du gendarme et du voleur".

Les clips animés pro-Kremlin circulent eux largement en Afrique depuis plusieurs années. Leur message est simple : présenter la France comme une puissance prédatrice et la Russie comme un allié sécuritaire. En 2023, un clip a mis ainsi en scène des armées africaines repoussant un envahisseur français grâce à l’aide de combattants arborant l’insigne de Wagner, au Mali, au Burkina Faso puis en Côte d’Ivoire.

La désinformation dans des groupes fermés

Autre tendance préoccupante : l’infiltration croissante dans des groupes WhatsApp privés, difficiles à surveiller.

Si leur portée reste limitée, leur opacité en fait un outil redoutable pour diffuser des récits conspirationnistes ciblés, non détectés par les plateformes ou les journalistes.

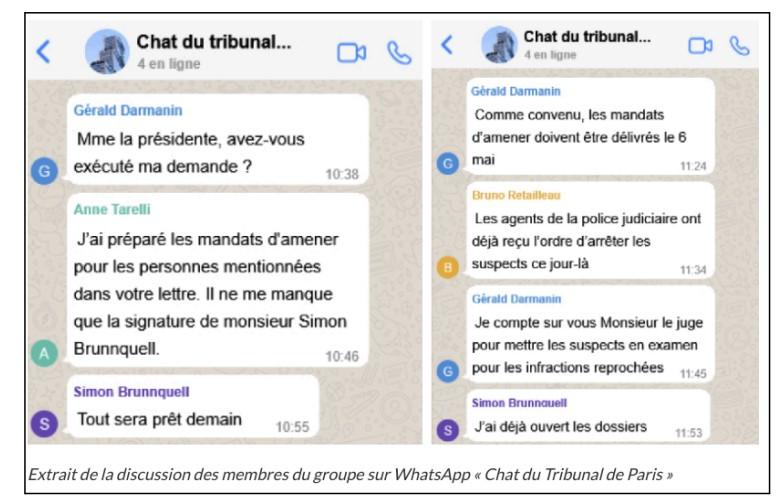

En avril 2025, les chercheurs du Gnida Project ont ainsi révélé que lequotidienfrancais - un faux média lié à CopyCop - relayait un récit accusant le gouvernement français de préparer des mandats d’arrêt contre des figures de l'extrême droite. Pour appuyer cette allégation, le site publiait un extrait de conversation WhatsApp présenté comme provenant d’un "Chat du Tribunal de Paris". Le groupe prétendait discuter de poursuites visant Marine Le Pen, Marion Maréchal, Sarah Knafo et Florian Philippot.

L'AFP a déjà publié de nombreux articles sur différents exemples de désinformation prorusse (ici, ici et ici).

Corrige prorusse (et non pro-russe)5 décembre 2025 Corrige prorusse (et non pro-russe)

Copyright AFP 2017-2026. Toute réutilisation commerciale du contenu est sujet à un abonnement. Cliquez ici pour en savoir plus.