Attention à ces vidéos générées par IA qui vantent de pseudo-remèdes santé et bien-être

- Publié le 17 avril 2025 à 12:20

- Lecture : 6 min

- Par : Cintia NABI CABRAL, Dounia MAHIEDDINE, AFP France

Fatigue, petite poitrine, cheveux abîmés ou troubles sexuels : des dizaines de comptes proposent des "solutions" dites naturelles sur TikTok (1, 2), Instagram (1, 2) ou encore YouTube (1, 2, 3).

Dans une vidéo publiée le 8 janvier 2025, visionnée plus de 425.000 fois, une jeune femme affirme avoir été "la stewardess de yacht la mieux payée pendant 9 ans" au service "d’un des hommes les plus riches de France". Elle évoque des "choses étranges" qu'on lui aurait imposées, avant d'enchaîner avec des conseils pour "améliorer l'odeur intime", " éliminer la rétention d’eau" ou encore "dégonfler le visage".

Des comptes comme "Santeplus.france", "santnergie.boost" ou encore "santeconseils" cumulent des centaines de milliers d'abonnés. Leurs publications suivent des formats répétitifs : témoignages face caméra, personnages en bas de l'écran, images illustratives (parfois générées par IA) en arrière-plan, appel à commenter, et lien d'achat situé dans la bio (petit texte de présentation situé sous le nom d'utilisateur).

Sur Instagram, elles prennent aussi la forme de carrousels (série de photos à faire défiler) où la dernière image redirige vers un produit (comme ici et là).

Mais derrière ces contenus se cachent des "mannequins numériques" générés par IA.

Selon un rapport publié le 4 mars 2025 par l'organisation américaine Media Matters for America, spécialisée dans la veille des médias et la lutte contre la désinformation, ces comptes s'inscrivent dans une stratégie commerciale opaque. "Certains de ces comptes utilisent des influenceurs deepfake comme vendeurs, inventant des histoires élaborées pour promouvoir la vente de produits et stimuler l’engagement des utilisateurs", peut-on lire (lien archivé ici).

"Quiconque est derrière ces comptes essaie de capitaliser sur l'obsession du bien-être sur internet. Presque chaque nom d'utilisateur contient une combinaison de mots-clés liés au bien-être, et les comptes vendent exclusivement des produits de santé et de beauté", souligne le document.

RomySauvayre, spécialiste des sciences et des croyances à l'Université Clermont-Auvergne, met en garde contre les confusions possibles entre ces faux comptes et des entités officielles. Exemple : "santeplus.france" pourrait être confondu avec "Santé publique France".

Anne-Laure Laratte, diététicienne-nutritionniste (lien archivé), dénonce les contenus "FakeMed" – ces publications qui promeuvent des produits miracle sans fondement scientifique. "Ils mêlent du vrai au faux, ce qui les rend plus crédibles." Certains éléments ont un intérêt nutritionnel, comme "les algues riches en minéraux" ou "le pollen d'abeille", mais ils servent à légitimer des compléments inutiles comme le shilajit. "Il n'y a pas d'aliment miracle. Et si besoin, c'est à un médecin de le prescrire."

Des mannequins numériques

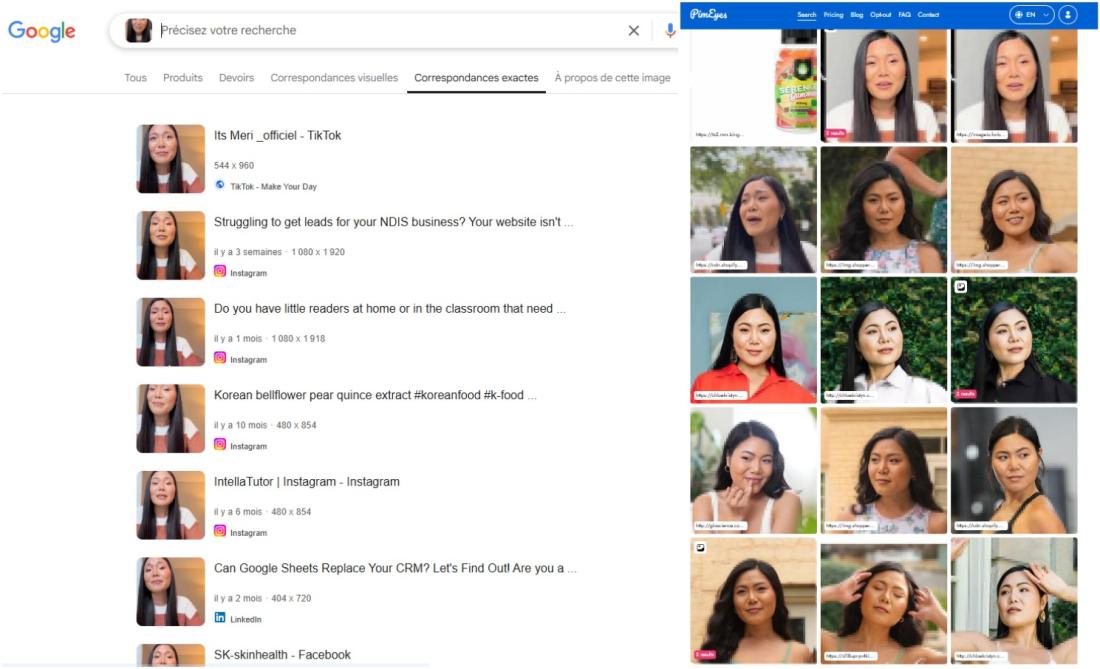

Une recherche d'image inversée sur certaines vidéos a montré que le même visage apparaît dans différents contenus : même tee-shirt, même coiffure, mais discours et langue différents.

La même personne incarne tour à tour une ancienne hôtesse de yacht, une médecin en exercice depuis sept ans, une spécialiste de la "médecine de l'intestin" ou encore la fille "'des chirurgiens plastiques les plus connus de Paris". Elle est également utilisée dans des séquences relayant les propos de figures controversées de la médecine alternative, comme Barbara O’Neill (comme ici et là).

Pour identifier cette personne, l'AFP a utilisé l'outil de reconnaissance faciale PimEyes. Résultat : il s'agit de Jennie Jaturapatporn, une créatrice de contenus basée à Los Angeles et qui se définit comme "actrice commerciale" sur son profil Instagram.

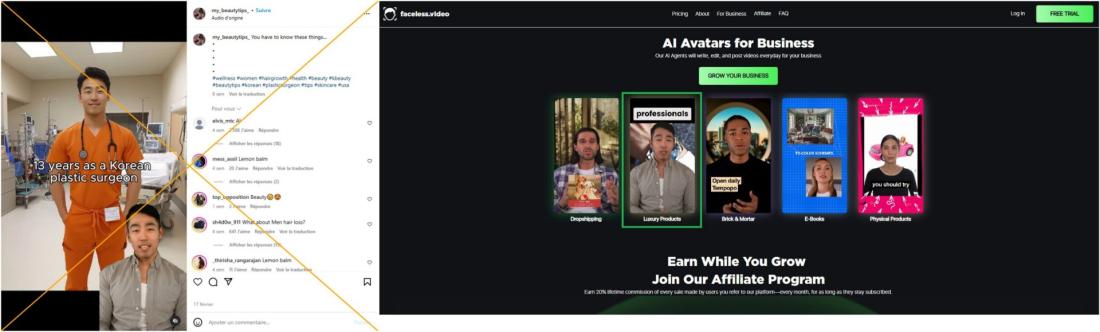

Si cette femme est partout, c'est parce qu'elle a cédé les droits sur son visage et sa voix à des sociétés créant des contenus à base d'IA à partir de l'image de réels acteurs. Moins coûteuse qu'un véritable tournage avec des comédiens, mais plus réaliste qu'un avatar entièrement généré par IA, cette technologie permet de constituer de vastes catalogues de "mannequins" numériques pour animer des vidéos, la plupart du temps pour vanter des produits ou des services.

Mais entre jargon juridique, clauses parfois abusives et argent vite gagné, certains peinent à comprendre pleinement ce à quoi ils s'engagent en vendant leur image.

L'acteur et mannequin sud-coréen Simon Lee en a fait les frais. Présenté tantôt comme chirurgien, tantôt comme gynécologue, on voit son avatar vanter des pseudo remèdes. Dans ces vidéos, son double numérique fait la promotion de prétendus remèdes, tels que se masser la poitrine avec des graines de figues pour en prévenir l’affaissement, ou encore appliquer du miel sur le visage comme masque anti-acné. Des vidéos qui servent avant tout de prétexte pour promouvoir un produit pour cheveux vendu sur Amazon.

Contacté par l'AFP le 18 mars 2025, l'acteur confirme avoir travaillé pour une entreprise qui génère du contenu IA : "C'est énervant. Si c'était une publicité correcte, ça ne m'aurait pas dérangé. Mais là, c'est clairement une arnaque", confie-t-il à l'AFP. Il aimerait faire retirer les vidéos, mais son contrat stipule que son image "peut être utilisée par des tiers".

"Les gens peuvent être conscients que c'est généré par l'IA, mais ça ne les dérange pas vraiment, car ces vidéos sont engageantes et leur parlent directement", explique Henry Ajder, spécialiste de l'intelligence artificielle et des deepfakes. Selon l'expert, ces témoignages exploitent des insécurités pour attirer l'attention des internautes.

Si ces plateformes sont si recherchées c'est parce qu'"elles offrent peu de modération et de mesures de sécurité", rajoute M. Ajder. Cela permettrait aux utilisateurs de faire dire à ces avatars ce qu'ils veulent, que le contenu soit frauduleux ou non, rendant ces sites facilement exploitables.

Une journaliste de l'AFP a pu, par exemple, faire dire des énormités à un avatar disponible sur le site HeyGen. Contactée, la plateforme n'a pas répondu.

"L'IA n'a fait qu'amplifier des pratiques frauduleuses que nous observons depuis longtemps", pointe Henry Ajder. Il rappelle que grâce aux technologies actuelles, il est désormais possible de générer des avatars avec de vraies personnes, capables de parler différentes langues et d'adopter divers accents, rendant ces escroqueries encore plus efficaces. "Cela permet de produire du contenu en masse avec moins d'investissement financier et en peu de temps", souligne l’expert.

"Dans les mécanismes de la croyance, si on utilise un témoignage, on a une plus grande force de conviction", a précisé à l’AFP Romy Sauvayre. Selon la sociologue, un récit incarné semble souvent plus convaincant qu'un article scientifique, en particulier pour les adeptes des médecines alternatives.

"L'avantage des réseaux sociaux, c'est qu'on parle de manière plus libre que ce que l'on pourrait faire dans la vie réelle", poursuit la sociologue, affirmant que les plateformes numériques encouragent certaines personnes à chercher des réponses sur des sujets parfois "tabous" en ligne, sans consulter de véritables professionnels de santé.

Les sujets abordés sont souvent considérés comme honteux: éjaculation précoce, odeurs intimes... "C'est dangereux, car ça laisse croire que le corps humain n'est pas fait correctement", alerte Anne-Laure Laratte.

Les arnaques en ligne : un phénomène ancien amplifié par l’IA

Contactée par l'AFP le 28 mars, la Direction générale de la concurrence, de la consommation et de la répression des fraudes (DGCCRF) a affirmé qu'elle continuait "d'accroître la pression de contrôle sur les pratiques commerciales des influenceurs en intensifiant le nombre de contrôles et en élargissant le spectre des contrôles à la variété des domaines d’influence", dont les "influenceurs mode, beauté ou 'lifestyle'".

"La DGCCRF a par ailleurs engagé un travail de coopération avec les plateformes pour qu’elles suspendent plus rapidement les comptes contrevenants", a-t-elle déclaré à l’AFP. Elle précise que les personnes promouvant des produits ou services à l’aide de contenus générés par intelligence artificielle sont soumises aux mêmes obligations légales que les influenceurs utilisant leur propre image.

Selon la DGCCRF, sur 260 influenceurs contrôlés en 2024, environ 40 % présentaient des "anomalies", dont l'absence d'indication du caractère commercial des publications, des allégations non vérifiées en matière de santé et de cosmétiques, de fausses promotions, ainsi que des publicités pour des loteries, des produits financiers, des paris sportifs ou des systèmes de vente pyramidale

Ces obligations incluent, entre autres, la mention explicite du caractère commercial des publications (en cas de rémunération directe ou indirecte), ainsi que le respect des règles encadrant la publicité dans des secteurs sensibles (jeux d’argent, produits financiers, santé, tabac, alcool, médicaments, etc.).

"La production par tous procédés d'intelligence artificielle visant à représenter un visage ou une silhouette est accompagnée de la mention: 'Images virtuelles'", peut-on lire sur le guide de bonne conduite en matière d'influence commerciale de la DGCCRF.

L'AFP s'est déjà penchée sur la promotion de produits frauduleux ici.

Copyright AFP 2017-2026. Toute réutilisation commerciale du contenu est sujet à un abonnement. Cliquez ici pour en savoir plus.