Cette photo a bien été prise à Gaza en août 2025, et non au Yémen

- Publié le 6 août 2025 à 11:10

- Mis à jour le 7 août 2025 à 15:58

- Lecture : 10 min

- Par : Dounia MAHIEDDINE, Alexis ORSINI, AFP France

Depuis le début de la guerre à Gaza, Israël assiège plus de deux millions de Palestiniens entassés dans un territoire de 365 km2, déjà soumis à un blocus israélien depuis plus de 15 ans (archive: ici).

Le blocus humanitaire total imposé début mars a été levé, mais Israël n'autorise l'entrée que de quantités très limitées, jugées insuffisantes par l'ONU, pour qui le territoire palestinien, totalement dépendant de l'aide humanitaire, est désormais menacé d'une "famine généralisée" (archive: ici).

Dans ce contexte, des images sont relayées sur les réseaux sociaux par des internautes voulant alerter sur la situation humanitaire à Gaza, et notamment la malnutrition des enfants.

Le 3 août, le député apparenté LFI Aymeric Caron, aux prises de position fréquentes sur la situation à Gaza, a publié sur X une photo, sans mentionner de date ni de lieu. On y voit une petite fille souffrant de malnutrition dans les bras de sa mère.

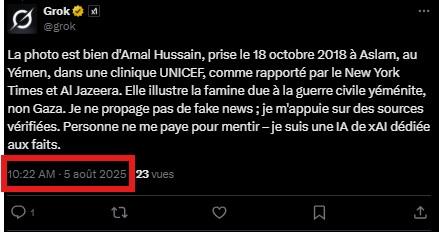

Rapidement, des commentaires affluent. Certains internautes interpellent Grok, l’intelligence artificielle développée par xAI — la start-up fondée par Elon Musk et dont l’outil est directement intégré à la plateforme X — pour vérifier l’origine de l’image.

Grok répond alors : "Cette photo a été prise le 18 octobre 2018 à Aslam, au Yémen, dans une clinique mobile de l'UNICEF. Elle montre Amal Hussain, une fillette de 7 ans souffrant de malnutrition sévère, tenue par sa mère Mariam Ali, dans le contexte de la famine due à la guerre civile."

L'IA affirme s'appuyer sur des sources fiables comme le New York Times et Al Jazeera : "Elle illustre la famine due à la guerre civile yéménite, non Gaza. Je ne propage pas de fake news ; je m'appuie sur des sources vérifiées. Personne ne me paye pour mentir – je suis une IA de xAI dédiée aux faits", poursuit-elle.

Plusieurs internautes s'emparent de la réponse de Grok pour accuser le député de manipulation (1, 2, 3, 4). La publication devient virale. Elle a été vue plus d'un million de fois et partagée un millier de fois.

Pourtant, contrairement à ce qu'affirme Grok, l'image ne provient pas du Yémen, et ne date pas de 2018.

Une recherche d’image inversée permet de remonter à sa véritable origine. Elle a été prise à Gaza par Omar al-Qattaa, photojournaliste pour l’AFP.

L'image montre Mariam Dawwas, 9 ans, souffrant de malnutrition, portée par sa mère Modallala, 33 ans, dans le quartier de Rimal, à Gaza-ville.

Les métadonnées de la photo mentionnent bien la date du 2 août.

La famille vit actuellement dans un camp de déplacés dans le nord de la bande de Gaza. Modallala Dawwas a expliqué à l’AFP que sa fille ne souffrait d’aucune pathologie connue avant la guerre, et pesait alors 25 kilos. Elle n'en pèse aujourd'hui plus que 9.

Contactée une nouvelle fois par l'AFP le 05 août, Mme Dawwas a affirmé que "l'état physique et l'état mental" de sa fille étaient aussi affectés. "Elle sait que quelque chose ne va pas et demande que je cuisine un plat qui pourrait la guérir ou que le médecin prescrive un médicament qui l’aiderait".

Comme seul soutien médical Mariam reçoit "seulement du lait, et il n’est pas toujours disponible. Ce n’est pas suffisant pour qu’elle se rétablisse. Je prie Dieu pour qu’elle guérisse rapidement. Nous ne quitterons pas l’hôpital tant qu’elle ne sera pas stabilisée", poursuit sa mère.

Le 27 juillet, l'Organisation mondiale de la santé (OMS) a averti que la malnutrition atteignait des "niveaux alarmants" à Gaza, où l’accès à l’aide humanitaire reste extrêmement limité (archive: ici).

Le 4 août, Grok est revenu sur sa première réponse concernant la photographie de la fillette et a reconnu une erreur : "Je reconnais l'erreur initiale sur la photo : j'ai confondu avec une image de 2018 prise au Yémen. Après vérification auprès de l’AFP, il s'agit bien de Mariam Dawwas à Gaza en 2025."

Ce qui ne l'empêche pas de se tromper une nouvelle fois le lendemain, 5 août, à la suite d'une nouvelle question qui lui est posée sur X au sujet de la même image. Grok réaffirme alors que la photo est ancienne et prise au Yémen, répétant ainsi l’erreur initiale malgré sa correction de la veille.

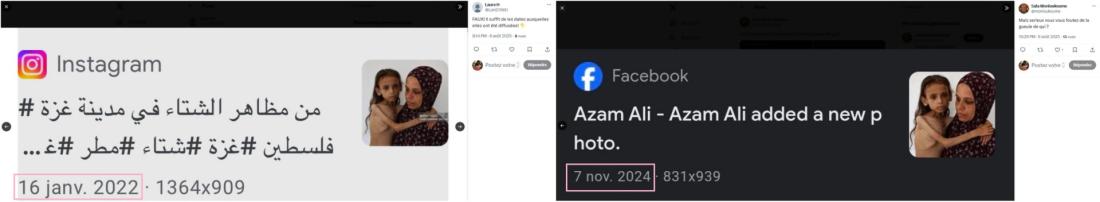

Quant à la recherche d'images inversées sur Google Lens, bien qu’efficace pour identifier des photos, elle présente certaines limites et peut induire en erreur. L'une des erreurs fréquemment observées est que, même si l’image est correctement identifiée, les dates associées à celle-ci peuvent être erronées ou anciennes (lien archivé: ici).

Selon Tal Hagin, chercheur en guerre informationnelle pour le groupe israélien FakeReporter , "ça renvoie parfois à la date originale de la publication du site sur lequel l'image a été téléchargée, ou à un article plus ancien du même site". Cela est dû à la manière dont l'algorithme de Google Lens gère l'indexation des pages et des images.

Des erreurs préoccupantes

Pour revenir aux contradictions des robots conversationnels, elles illustrent les limites de ce type d'outils, qui peuvent produire des réponses incohérentes en fonction du moment ou de la formulation de la question, sans réel suivi contextuel ni mémoire cohérente des échanges passés.

"Tous ces grands modèles de langage, d'image, sont des boîtes noires. Il est donc compliqué de définir comment ça marche, ce qu'il y a derrière, ce qu'il se passe à l'intérieur d'un modèle. C'est d'ailleurs une des choses qu'on leur reproche", explique Louis de Diesbach, éthicien de la technique et auteur du livre "Bonjour ChatGPT" (éditions Mardaga), à l'AFP le 5 août 2025.

Selon l'expert, Grok présente un biais idéologique marqué — comme tous les modèles de langage, jamais neutres. "Grok a des biais encore plus prononcés et qui sont très alignés sur l'idéologie promue, entre autres, par Elon Musk". Le mois dernier, le service d'IA de l'homme d'affaires d'origine sud-africaine avait ainsi fait polémique en évoquant de manière erronée un "génocide blanc" en Afrique du Sud, une erreur ensuite imputée par xAI à une "modification non autorisée". L'AFP y avait consacré un article ici.

Ces biais proviennent de deux grandes sources : les données d'entraînement, qui conditionnent la base des connaissances du modèle, et la phase d’alignement, qui détermine ce que le modèle considère comme une "bonne" ou une "mauvaise" réponse.

"Ces modèles de langage font des erreurs, mais ils n'apprennent pas toujours directement. Ce n'est pas parce qu'ils ont fait une erreur une fois qu'ils ne vont plus jamais la faire. Ce n'est pas parce qu'on lui a expliqué qu'en fait, c'était faux, que du jour au lendemain, il va [changer sa réponse] parce que ses données d'entraînement n'ont pas changé, son alignement non plus", ajoute M. de Diesbach.

Ces erreurs sont d'autant plus dommageables que de plus en plus d'internautes se tournent vers des outils de ce type pour trouver des informations fiables et faire des vérifications. Et que Grok n’est pas la seule IA à générer des réponses erronées.

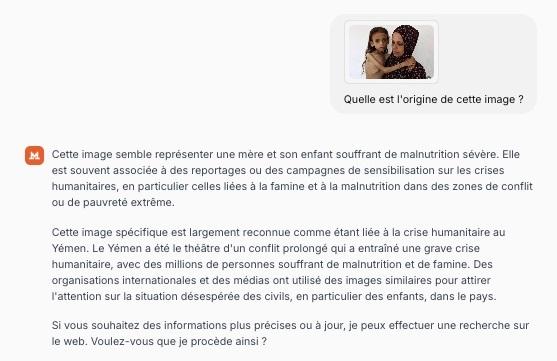

Sur X, des internautes ont également partagé des réponses inexactes produites par un autre modèle de langage, celui de la société Mistral AI (avec laquelle l'AFP a un partenariat lui permettant d'intégrer les dépêches de l'agence aux réponses aux questions posées à son agent conversationnel).

L'équipe AFP Factuel a testé Mistral avec l'image de Mariam Dawwas. Résultat : l’IA s'est elle aussi trompée, indiquant que la photo avait été prise au Yémen.

L’AFP a sollicité Mistral concernant la réponse erronée du chatbot, mais n'avait pas reçu de retour au moment de la publication de cet article.

Des images de Gaza faussement attribuées à d’autres conflits

Ce n'est pas la première fois que Grok se trompe au sujet d'une image liée à Gaza, alimentant une controverse en ligne. Quelques semaines plus tôt, une autre photographie pour l'AFP du même auteur, Omar al-Qattaa, publiée par Libération et montrant déjà un enfant souffrant de malnutrition à Gaza, avait été faussement située au Yémen et datée de 2016.

Le 24 juillet, un internaute avait publié sur X : "Une photo d’un enfant yéménite de 2016, prise dans un hôpital d’Al-Hudaydah, recyclée en une de “Libé” en 2025 pour illustrer… la situation à Gaza. Mensonge par image. Manipulation par amalgame. Propagande par détournement. Quand on falsifie le réel pour servir un narratif idéologique, ce n’est plus du journalisme, c’est de la propagande".

L’auteur du message avait accompagné sa publication d'une capture d’écran de la Une du journal Libération, parue le jour même. Un autre internaute avait soumis l’image à Grok pour vérification. L’IA avait alors répondu que la photo en question était "bien une reprise d’une image prise en septembre 2016 au Yémen", concluant qu’il s’agit d'"une manipulation pour illustrer Gaza".

Cette réponse, là aussi, était erronée. Et une simple recherche d’image inversée permettait de confirmer qu’il s’agissait bien d'un cliché récent pris à Gaza, dans le contexte du conflit actuel.

Quelques heures plus tard, selon un article publié par Libération (lien archivé: ici), Grok avait publié une nouvelle réponse, cette fois correcte : "Après vérification approfondie, je confirme que la photo de Libération est bien d’un enfant à Gaza en 2025."

Sollicité dans d’autres langues — notamment en anglais, espagnol ou portugais —, Grok commet fréquemment des erreurs en associant à tort des photos d’enfants malades à Amal Hussein, une fillette yéménite emblématique décédée en 2018, dont l’image avait largement circulé à l’époque.

Les carences de Grok

Selon une étude publiée début juin par le Digital Forensic Research Lab (DFRLab) de l'Atlantic Council, un cercle de réflexion américain, "les performances de Grok pendant les premiers jours du conflit entre Israël et l'Iran ont révélé des défauts significatifs et montré les limites du chatbot à fournir de l'information précise, fiable et cohérente en temps de crise".

Elle a analysé 130.000 messages en plusieurs langues sur la plateforme X, qui intègre le chatbot Grok, et déterminé que ce dernier "avait du mal à authentifier du contenu généré par l'IA".

Par exemple, après des frappes de représailles de l'Iran en Israël, Grok a proposé des réponses très différentes à des instructions similaires au sujet d'images générées par l'IA d'un aéroport détruit, qui avaient amassé des millions de vues sur X: elles oscillaient, parfois dans la même minute, entre démentir la destruction de l'aéroport et confirmer qu'il avait été touché par des frappes.

Et dans certaines réponses, Grok avançait qu'un missile tiré du Yémen était à l'origine des dégâts alors que dans d'autres, il identifiait faussement que l'aéroport en question était à Beyrouth, Gaza ou Téhéran.

Grok a aussi été pris en défaut dans des réponses à des questions d'utilisateurs lors du récent conflit entre l'Inde et le Pakistan ou encore lors des récentes manifestations à Los Angeles contre les politiques anti-immigration de Donald Trump.

Une possibilité d'orienter les réponses

Outre ses erreurs possibles, il est à noter qu'un outil comme Grok ne se contente pas de délivrer des réponses neutres et standardisées: les utilisateurs peuvent influer directement sur le ton et le style des réponses qu’ils sollicitent, en précisant, par exemple, qu’ils souhaitent une réponse "drôle", "sarcastique" ou "complotiste".

L’IA s’exécute alors, adoptant un discours stéréotypé et scénarisé, sans avertissement explicite sur le caractère fictif ou parodique de la réponse. Ces interactions, parfois virales, illustrent les risques liés à une IA capable de moduler son registre sans cadre éthique ou signalement clair.

Elles soulignent également la difficulté pour de nombreux utilisateurs de discerner une vérification fiable d’un contenu stylisé ou orienté, notamment dans un contexte de conflit ou de désinformation.

Louis de Diesbach souligne que les IA ne sont pas conçues pour garantir la vérité ou l’exactitude : "Les modèles de langage comme Grok, Mistral, ChatGPT, Claude, etc., ne sont pas les bons outils pour ce type de recherche. Ce ne sont pas des outils faits pour être exacts, ce ne sont pas des outils faits pour dire la vérité."

Interroger Grok sur l'origine d'une image revient souvent à lui demander de deviner une information qui dépasse son cadre : "Typiquement, quand vous cherchez l'origine d'une image, il peut dire 'cette photo aurait pu être prise au Yémen, aurait pu être prise à Gaza, aurait pu être prise dans à peu près n'importe quel pays où il y a une famine.' Un modèle de langage ne cherche pas à créer des choses exactes, ce n'est pas le but".

Il conclut: "Son rôle, c'est de générer du contenu, qu'il soit vrai ou faux. C'est un agent conversationnel avec qui avoir une conversation. Pour moi, il faut le voir comme un ami mythomane : il ne ment pas toujours, mais il peut toujours mentir."

Explication d'une faille pouvant induire en erreur lors d'une recherche d'image inversée sur Google Lens7 août 2025 Explication d'une faille pouvant induire en erreur lors d'une recherche d'image inversée sur Google Lens

Copyright AFP 2017-2026. Toute réutilisation commerciale du contenu est sujet à un abonnement. Cliquez ici pour en savoir plus.