Attention à ces vidéos usurpant l'identité de médecins connus pour donner des conseils en santé

- Publié le 6 février 2026 à 18:21

- Lecture : 7 min

- Par : Chloé RABS, AFP France

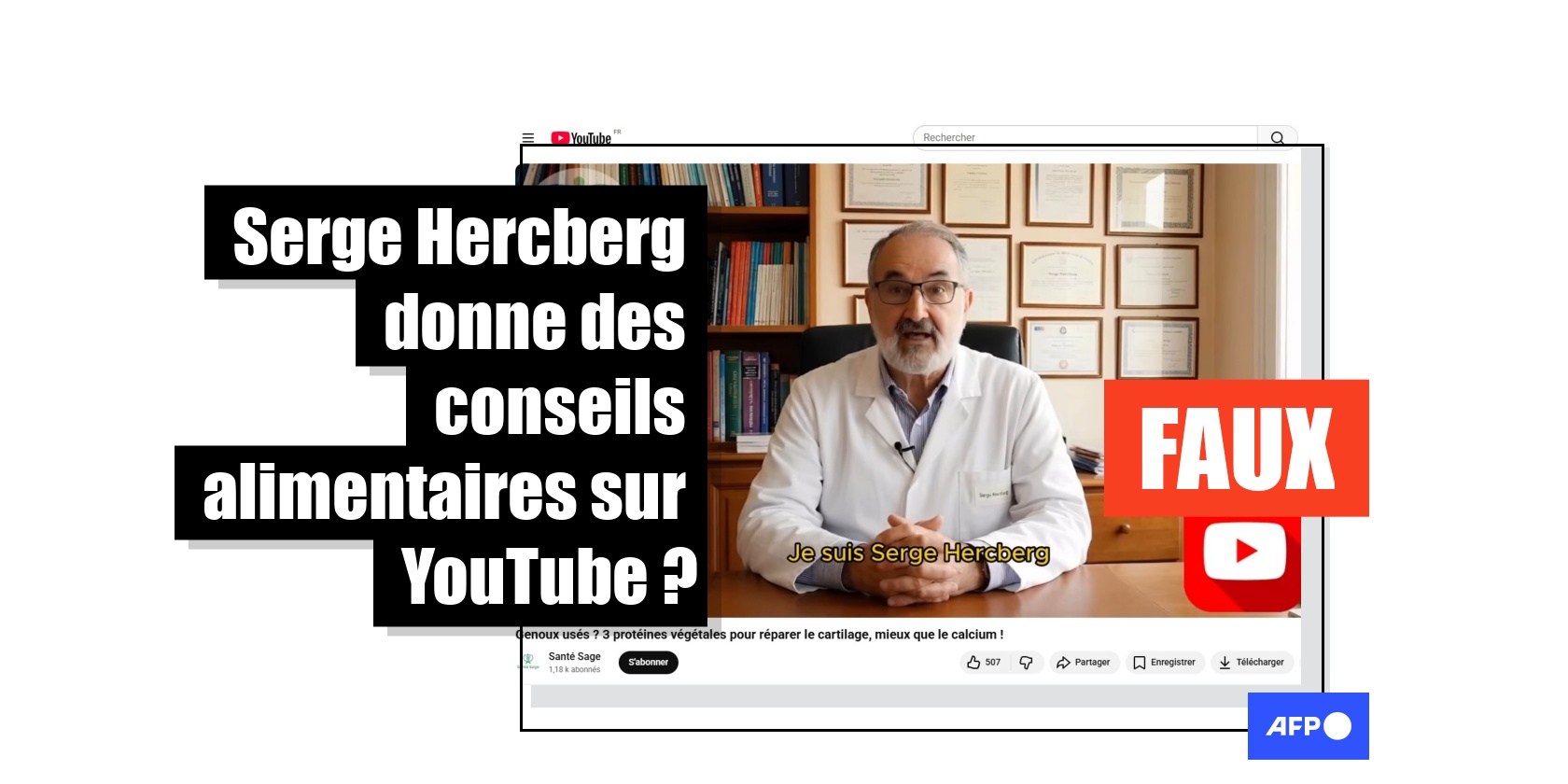

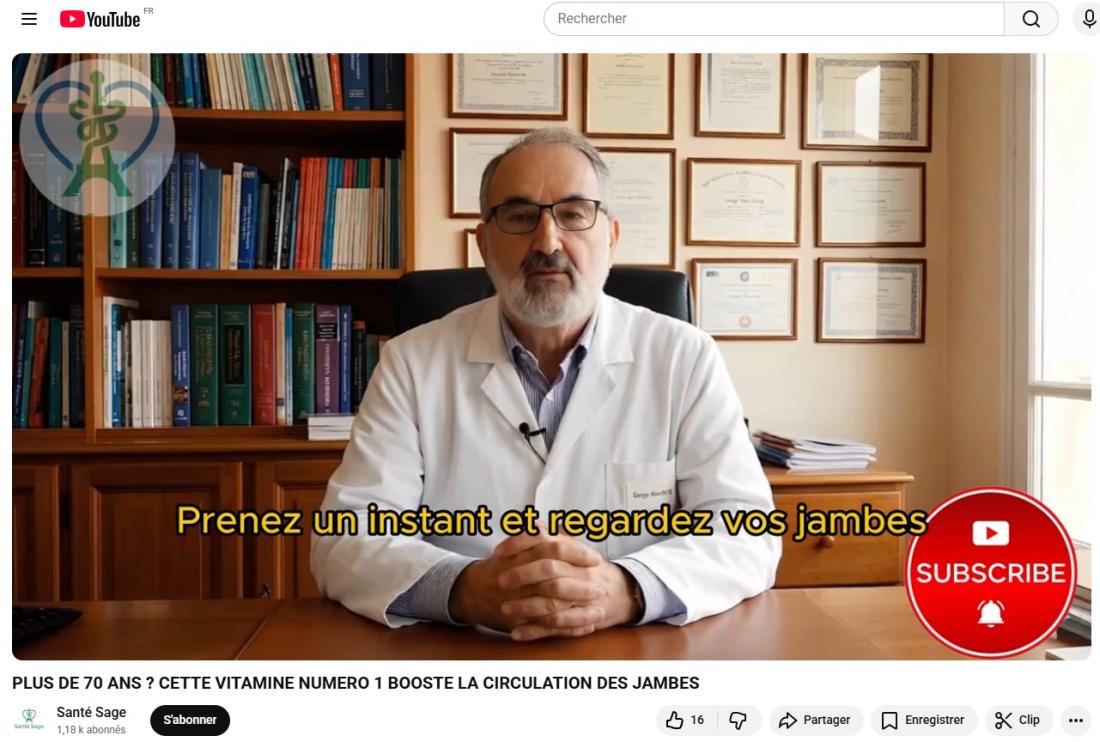

Des conseils nutritionnels pour ralentir la démence, booster la circulation des jambes ou reconstruire vos muscles : sur YouTube, un compte créé fin décembre partage des vidéos usurpant l'identité du nutritionniste Serge Hercberg, dernière victime en date de ces deepfakes à base d'intelligence artificielle qui se multiplient ces dernières années.

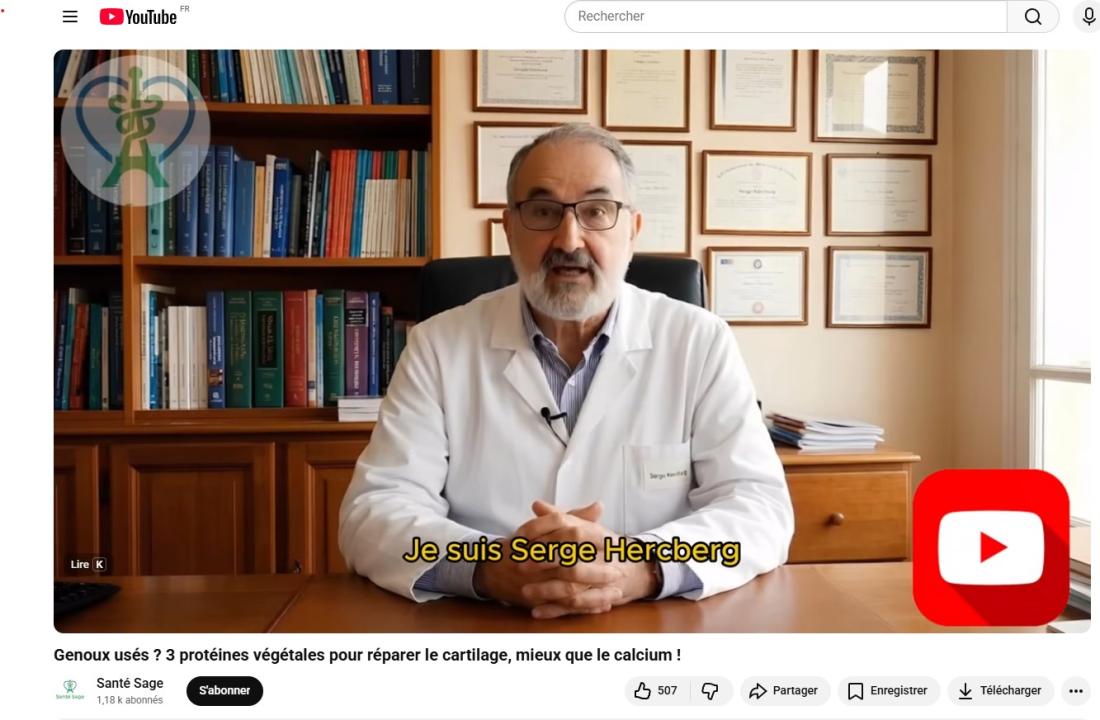

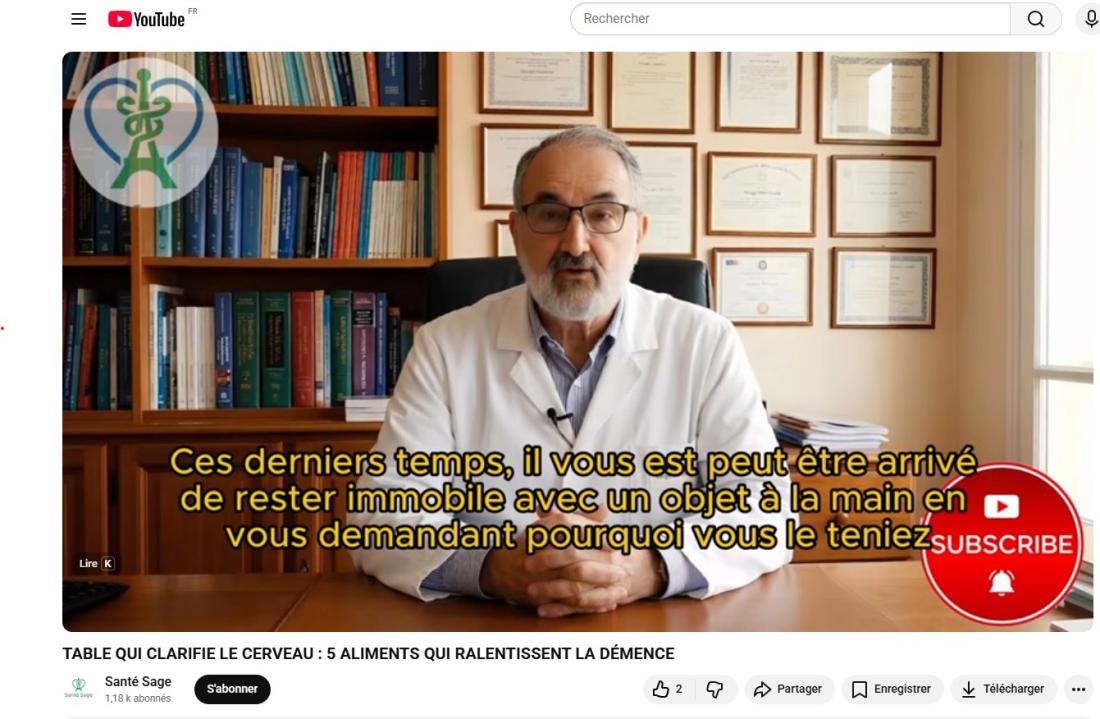

"Bienvenue sur Santé Sage, l’espace bienveillant dédié à la santé du cerveau et des os pour les personnes de plus de 60 ans", se présente une chaîne YouTube, qui a publié 29 vidéos depuis sa création le 31 décembre 2025.

Dans chacune d'entre elles, un médecin en blouse blanche, Serge Hercberg - nutritionniste connu pour être à l'origine du Nutri-Score -, assis à son bureau, semble donner des conseils nutritionnels pour combattre les douleurs articulaires ou protéger ses artères.

Problème : l'ensemble de ces vidéos ont été générées par intelligence artificielle et ne font qu'usurper l'identité du nutritionniste.

"Des vidéos circulent sur internet usurpant mon image, ma voix et mon identité. Réalisées avec une IA, ces deepfakes me mettent en scène en blouse blanche (avec mon nom brodé sur la poche), assis dans un bureau 'médical' (qui n’a bien sur aucune existence réelle) et me font émettre des propos plus ou moins ésotériques sur l’effet de certains aliments, certains nutriments ou certains comportements sur la santé, notamment osseuses et cérébrales des sujets âgés... Des propos que, bien sur, je n’ai jamais tenus…", a réagi le 5 février Serge Hercberg sur son compte LinkedIn (lien archivé ici)

Contacté par l'AFP, le nutritionniste explique avoir été alerté par un de ses collègues qui est tombé "par hasard" sur ces vidéos. "C'est la première fois que je suis victime de deepfakes, c'est vraiment très troublant", confie-t-il.

S'il reconnait que les propos qu'on lui fait tenir ne représentent pas de dangers et sont assez "absurdes", il s'inquiète du développement de cette "nouvelle stratégie visant des scientifiques" qui pourrait être utilisée pour passer des messages "à l'encontre des recommandations de santé publique" et contribuer encore plus à "brouiller les messages importants".

"Reprendre l'image de scientifiques permet de donner une crédibilité. Là, il n'y a rien de dangereux, mais que se passera-t-il quand ce compte aura appâté plus de personnes et qu'il me fera faire la promotion de produits miracles ?"

Malgré "quelques imperfections dans certaines prononciations", ces vidéos sont "globalement assez bien réalisées", dans un temps "assez court", et sans détourner un extrait d'interview par exemple, mais en créant une situation de toute pièce : bureau, blouse, nom brodé...

Serge Hercberg déclare avoir fait un signalement sur Pharos, le portail gouvernemental de signalement des contenus illicites de l'Internet, ainsi qu'auprès de la plateforme YouTube. Il appelle aussi à la mise en place d'une meilleure "réglementation pour dissuader l'utilisation de cette technologie pour détourner l'image de scientifiques".

"Une réponse juridique doit être apportée à de tels comportements malhonnêtes", plaide-t-il.

De son côté, YouTube affirme à l'AFP que l'usurpation d'identité est "complètement interdite par notre Règlement de la Communauté" et que les personnes victimes peuvent soumettre une plainte via ce formulaire.

"En parallèle, nous développons des outils pour protéger les créateurs, c'est le cas de Likeness ID, pour aider les créateurs à repérer automatiquement sur YouTube les contenus où leur visage a été généré ou modifié par l'IA", explique YouTube.

"Si une correspondance est trouvée, le créateur peut examiner la vidéo et décider d'en demander le retrait via notre procédure de plainte pour atteinte à la vie privée."

Depuis la pandémie de Covid-19, YouTube affirme accélérer sa lutte contre la désinformation médicale, notamment contre les contenus anti-vaccins ou les fausses informations sur le cancer. La plateforme a aussi développé des outils pour mettre en avant les contenus venant des autorités sanitaires mais aussi d'hôpitaux et, en France, des messages d'information sous les vidéos pour aider l'utilisateur à identifier sa source.

En septembre 2025, YouTube avait toutefois annoncé réintégrer des créateurs jusqu'ici bannis de la plateforme pour avoir diffusé des informations erronées sur le Covid-19 et les élections américaines.

Un phénomène récurrent

Depuis plusieurs années, de nombreux médecins sont victimes de ces deepfakes sur les réseaux sociaux, où leur notoriété est utilisée pour faire la promotion de cures "miracles" contre différentes affections.

"Les gens ont confiance en ces vidéos car ces médecins ont passé du temps à se construire une image de crédibilité, donc on les croit, même quand ils formulent des allégations totalement farfelues", déplorait dans cet article de l'AFP le Dr John Cormack, un généraliste britannique qui collabore avec le British Medical Journal (BMJ) sur ce sujet.

En 2024 déjà, des fausses vidéos mettant en scène le scientifique marseillais Didier Raoult ou le médecin médiatique Michel Cymes circulaient massivement, vantant des remèdes contre le diabète dont l'efficacité n'a jamais été prouvée.

En juillet 2024, la médecin généraliste et ex-Miss France Marine Lorphelin, victime aussi de ce type de vidéos, avait appelé à la prudence dans des vidéos publiées sur ses comptes Instagram et TikTok.

"Je n'en peux plus. Ces vidéos sont créées par une IA où on transforme mon visage et ma voix pour vous vendre des compléments alimentaires ou des produits miraculeux, soi-disant pour améliorer tel ou tel état de santé. Jamais je ne ferai la promotion d'aliments miracles ni de produits dont les effets n'ont pas été prouvés scientifiquement", avait-elle averti.

"Alerte ! L'IA m'a volé mon identité", dénonçait aussi en septembre 2025 sur sa chaîne YouTube "Doc FX", François-Xavier Moronval, médecin urgentiste à Epinal.

"Ce phénomène créé par l'intelligence artificielle est inquiétant pour les soignants et pour les patients car les conséquences peuvent être dramatiques", prévenait-il.

Dans sa vidéo, il donnait quelques conseils pour détecter ces fausses vidéos, comme les "lèvres désynchronisées par rapport à la voix", "des clignements de yeux trop rares", ou encore "des changements subtils dans l'éclairage du visage". Mais la qualité des deepfakes en images, audio et vidéo a fait des progrès énormes ces dernières années, qui compliquent de plus en plus l'identification de ces arnaques.

Des "mannequins numériques"

Sur Instagram ou TikTok, de nombreux contenus utilisent aussi des "mannequins numériques" générés par IA, présentés parfois comme des médecins, pour promouvoir là aussi des remèdes prétendument "miracle", censés améliorer le bien-être ou transformer nos corps, comme raconté dans cet article de l'AFP Factuel.

Des comptes comme "Santeplus.france", "santnergie.boost" ou encore "santeconseils" cumulent des centaines de milliers d'abonnés. Leurs publications suivent des formats répétitifs : témoignages face caméra, personnages en bas de l'écran, images illustratives (parfois générées par IA) en arrière-plan, appel à commenter, et lien d'achat situé dans la bio (petit texte de présentation situé sous le nom d'utilisateur).

"Ils mêlent du vrai au faux, ce qui les rend plus crédibles", expliquait Anne-Laure Laratte, diététicienne-nutritionniste (lien archivé). Certains éléments ont un intérêt nutritionnel, comme "les algues riches en minéraux" ou "le pollen d'abeille", mais ils servent à légitimer des compléments inutiles comme le shilajit, une huile minérale noirâtre. "Il n'y a pas d'aliment miracle. Et si besoin, c'est à un médecin de le prescrire."

Face à ces "deepfakes", les experts ne sont pas très optimistes quant au succès des outils de détection. "C'est le jeu du chat et de la souris", expliquait Frédéric Jurie, enseignant-chercheur en informatique de l'Université de Caen, dans cet article de l'AFP. "Par principe, la détection ne peut pas trop s'améliorer, parce que si quelqu'un trouvait quelque chose pour améliorer la détection, à ce moment-là, celui qui veut fabriquer des fausses images utiliserait ce moyen pour le contourner."

Copyright AFP 2017-2026. Toute réutilisation commerciale du contenu est sujet à un abonnement. Cliquez ici pour en savoir plus.