Attention, ces vidéos d'hommes sauvant des bébés chutant d'un balcon ont été générées par intelligence artificielle

- Publié le 4 décembre 2025 à 17:42

- Lecture : 10 min

- Par : Cintia NABI CABRAL, AFP France

Les contenus destinés à susciter des émotions fortes (colère, indignation, compassion... ) pullulent sur les réseaux sociaux, pour susciter des réactions et, in fine, des revenus pour leurs créateurs, qui n'hésitent pas parfois à créer des histoires de toutes pièces. Ainsi par exemple, depuis octobre 2025, plusieurs vidéos virales affirment qu'un passant ayant sauvé un enfant d'une chute depuis un balcon aurait ensuite été contraint de payer la somme de 500.000 dollars pour les blessures causées. Mais l'AFP n'a pas trouvé de trace d'une telle histoire, dont les noms des protagonistes diffèrent selon les versions, indice supplémentaire du fait qu'elle a été inventée. De plus, les prétendues images de surveillance ont été générées par intelligence artificielle (IA).

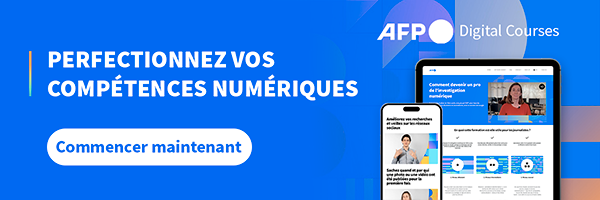

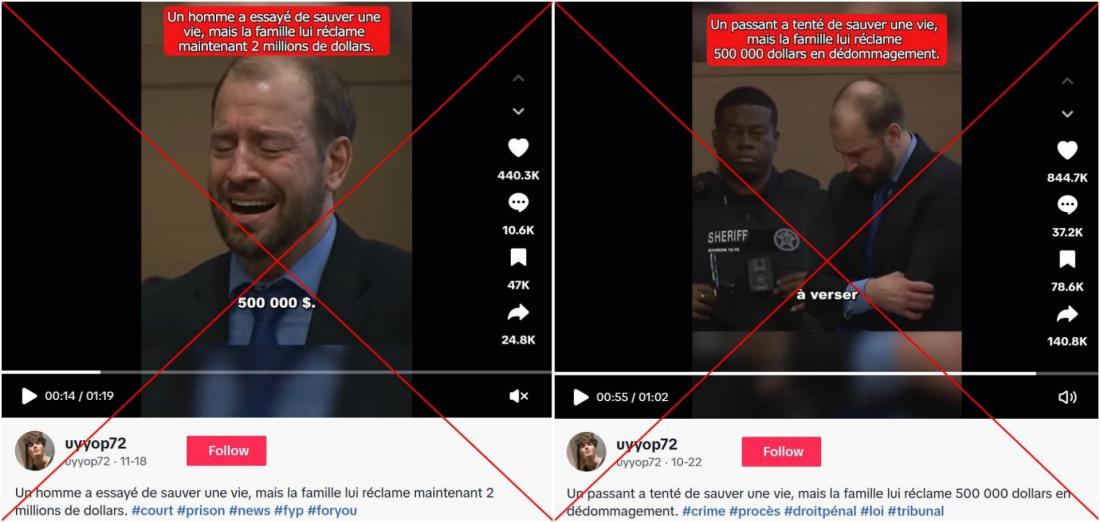

"Un homme de 26 ans, Ethan Carter, a rattrapé une fillette tombée du troisième étage, mais il a ensuite été condamné à payer 500.000 dollars", est-il affirmé dans une courte vidéo TikTok. Publiée le 18 novembre 2025, elle a déjà été partagée 25.000 fois, récoltant plus de 442.000 "j'aime" et 8,6 millions de vues.

Selon cette vidéo, "la petite Elena, âgée de trois ans, a glissé entre les barreaux du balcon. En entendant les cris, Ethan a couru dans le couloir et a tendu les bras de toutes ses forces pour la rattraper. Il a réussi, mais l'impact était si fort que l'enfant s'est fracturé les jambes et les bras et ne pouvait plus marcher".

Quelques jours après les faits, la mère de la fillette aurait porté plainte contre "Ethan", selon la vidéo, réclamant 2 millions de dollars et l'accusant de "sauvetage imprudent", affirmant que la manière dont il avait attrapé l'enfant avait provoqué ses fractures.

Le récit poursuit en expliquant que "l'avocat d'Ethan a soutenu qu'il s'agissait d'un accident et qu'il avait agi de bonne foi, selon la loi du Bon Samaritain de l'état de Washington", une loi qui protège les personnes qui interviennent de bonne foi en situation d'urgence (lien archivé ici).

Mais "après plusieurs semaines d'audience, les charges pénales ont été abandonnées. Même si son ami a témoigné en sa faveur, le tribunal civil a tout de même jugé Ethan responsable à 30% et l'a condamné à verser 500.000 dollars".

Face à cette histoire, également relayée sur Facebook (1, 2, 3), Instagram, TikTok (1, 2, 3), X et YouTube (1, 2), de nombreux internautes réagissent dans les commentaires, s'indignant qu'un homme présenté comme ayant sauvé "la petite Elena" puisse être condamné à payer une telle somme.

Mais attention : dans la vidéo ci-dessus, les images de la chute de l'enfant sont générées par intelligence artificielle (IA) et cette histoire est inventée, comme indiqué par son créateur.

Un récit aux multiples versions

Après plusieurs recherches par mots-clés en anglais, l'AFP n'a pas retrouvé aucun dossier judiciaire, aucun article de presse fiable ni aucune procédure judiciaire qui viendrait étayer l'histoire d'une personne condamnée à payer 500.000 dollars après avoir sauvé un enfant d'une chute.

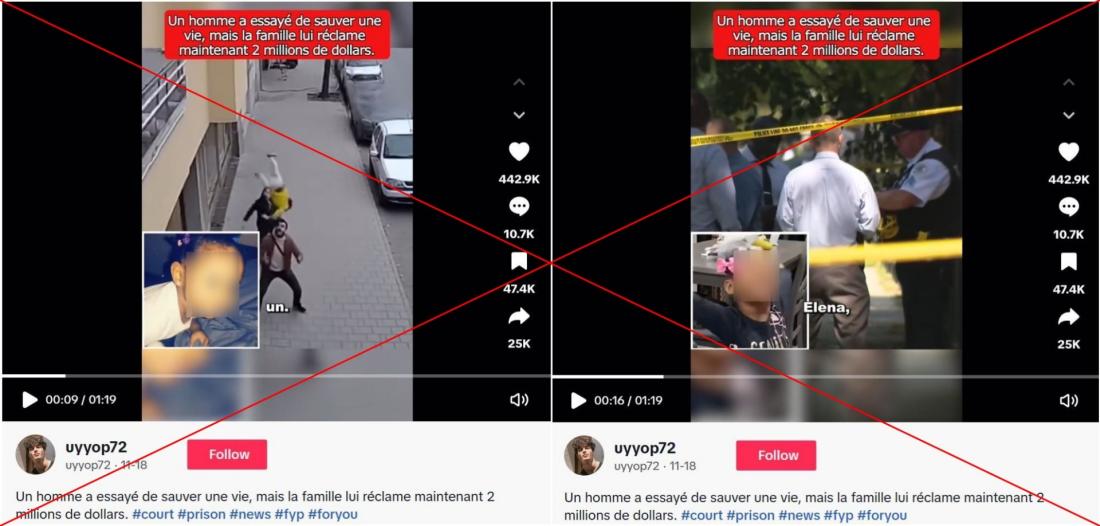

En revanche, une première analyse du compte TikTok qui a diffusé la vidéo permet de douter sur sa fiabilité : le 22 octobre 2025, on y trouve déjà une vidéo affirmant qu'un certain "Jason Miller", un homme de 25 ans, avait attrapé un enfant de deux ans tombé du cinquième étage, puis avait été "condamné à verser 500.000 dollars de dédommagement". Depuis, cette vidéo a été partagée 140.000 fois, récoltant près de 845.000 "j'aime" et plus de 10,6 millions de vues.

La même séquence a ensuite été repostée par le même compte, et diffusée par d'autres internautes sur Instagram (1, 2, 3, 4) et TikTok (1, 2, 3).

Mais là encore, il s'agit d'un récit qui semble inventé. On note d'ailleurs que les détails de cette histoire varient d'une version à l'autre : en plus des images illustrant le récit, le nom du prétendu "sauveur" change ("Ethan Carter" ou "Jason Miller"), tout comme son âge ("26" ou "25" ans), celui de l'enfant ("trois" ou "deux" ans), ou encore l'étage d'où l'enfant serait tombé ("troisième" ou "cinquième" étage). L'AFP a retrouvé plusieurs variantes de cette intox circulant en anglais depuis juillet 2025.

Le média de vérification brésilien Boatos avait déjà enquêté sur cette infox le 7 novembre (lien archivé ici).

Infox relayée par de faux médias d'actualité

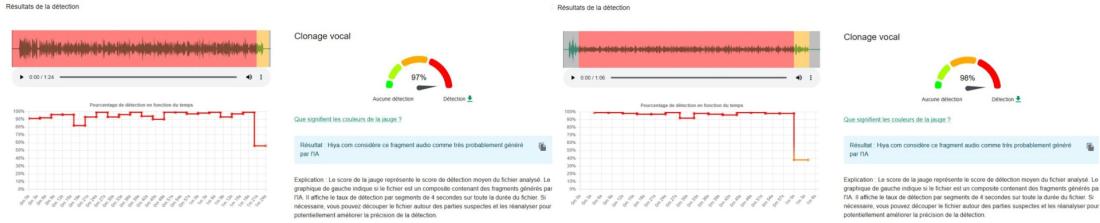

Des analyses des pistes audio de ces vidéos virales, réalisées à l'aide du détecteur de deepfakes Hiya.com sur l'outil (cocréé par l'AFP) de vérification InVID-WeVerify, estiment que les voix off ont été très probablement générées par intelligence artificielle (IA).

Depuis le début de l'année, des comptes comme "crime_actu01", "tikcrimewatch", "hahqwc19" ou encore "alarmeinfos01" cumulent des centaines de milliers d'abonnés.

De nombreuses fausses affirmations sensationnalistes sont postées sur ce type de comptes TikTok, qui reprennent des vidéos de vrais faits divers, mais véhiculent, en réalité, de la désinformation. Leur objectif ? Générer de l'audience, et donc des revenus. Ils s'appuient pour cela souvent sur du contenu produit rapidement, à partir de séquences vidéos (authentiques ou synthétiques) qu'on retrouve ailleurs sur internet, et d'une voix off générée par IA.

Ces récits sont conçus pour susciter de fortes émotions face à l'héroïsme, l'injustice ou encore la trahison, et donc, susciter de l'engagement (partages, likes, commentaires) qui permettent dans certains cas de monétiser ces contenus auprès des plateformes.

Images de faits divers recyclées

L'AFP a constaté que plusieurs images utilisées dans la vidéo virale sont en réalité issues de faits divers déjà documentés.

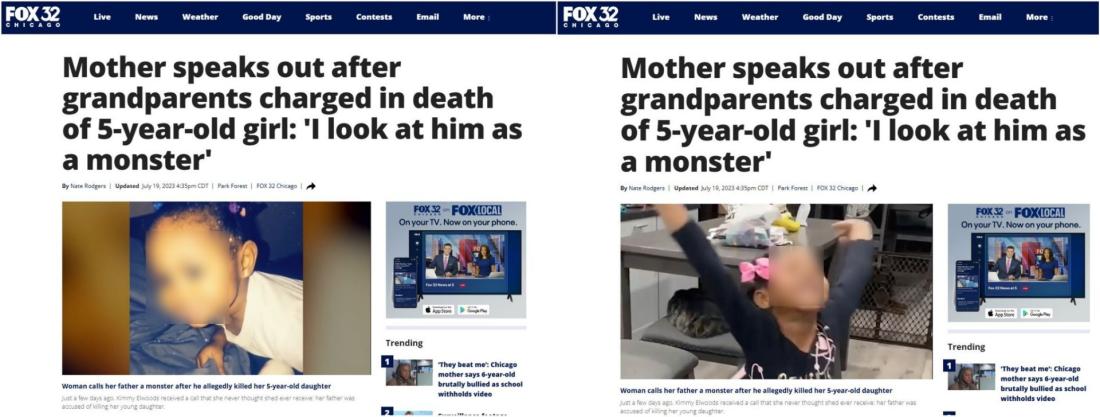

Pour tenter d'identifier "la petite Elena" à partir de la séquence vidéo et de son portrait, l'AFP a utilisé l'outil de reconnaissance faciale FaceCheck (lien archivé ici). Résultat : il s'agit Jada Moore, une fillette de 5 ans battue à mort par ses grands-parents en juillet 2023 dans l'état de l'Illinois, aux Etats-Unis. Les images diffusées dans la vidéo virale reprennent en réalité celles d'un reportage de la chaîne américaine FOX 32 Chicago, diffusé le 19 juillet 2023 (lien archivé ici).

Un autre exemple de réutilisation détournée concerne les deux vidéos virales reprenant l'image d'un homme en pleurs, vêtu d'une chemise et d'une cravate bleues, ainsi que d'une veste noire. Dans ces montages, il est faussement présenté sous les identités d'"Ethan Carter" ou de "Jason Miller", accompagnées d'histoires inventées de toutes pièces.

Une recherche d'images inversées a permis à l'AFP de retrouver la vidéo originale : l'homme est Stephen Matthews, un ancien cardiologue de Denver (Etats-Unis), âgé de 36 ans au moment des faits. La séquence provient d'un extrait diffusé par le média américain 9News sur YouTube le 13 août 2024 (lien archivé ici). Dans cette vidéo, on voit le juge énoncer les chefs d'accusation retenus contre M. Matthews.

Selon la description de cette vidéo, Stephen Matthews "a été arrêté en mars 2023 après qu'une femme ait signalé qu'il l'avait agressée après qu'ils soient allés bruncher". "Après que son histoire a été rendue publique, neuf autres femmes se sont manifestées pour signaler qu'elles avaient été victimes de Matthews. Ce dernier a accusé d'avoir drogué et agressé sexuellement plusieurs femmes après les avoir rencontrées sur des applications de rencontres comme Hinge et Tinder a été reconnu coupable de 35 des 38 chefs d'accusation par un jury mardi matin au tribunal de district de Denver", poursuit la description.

En outre, ni l'identité ni l'histoire de Jada Moore ou de Sthephen Matthews ne correspondent aux récits inventés dans les vidéos que nous vérifions dans cet article. Les images qui les montrent ont été décontextualisées et utilisées pour alimenter de fausses histoires en ligne.

Des "héros" générés par IA

Des recherches d'images inversées ont permis à l'AFP de retrouver les premières occurrences des vidéos que nous vérifions, montrant les sauvetages d'enfants tombés de balcons.

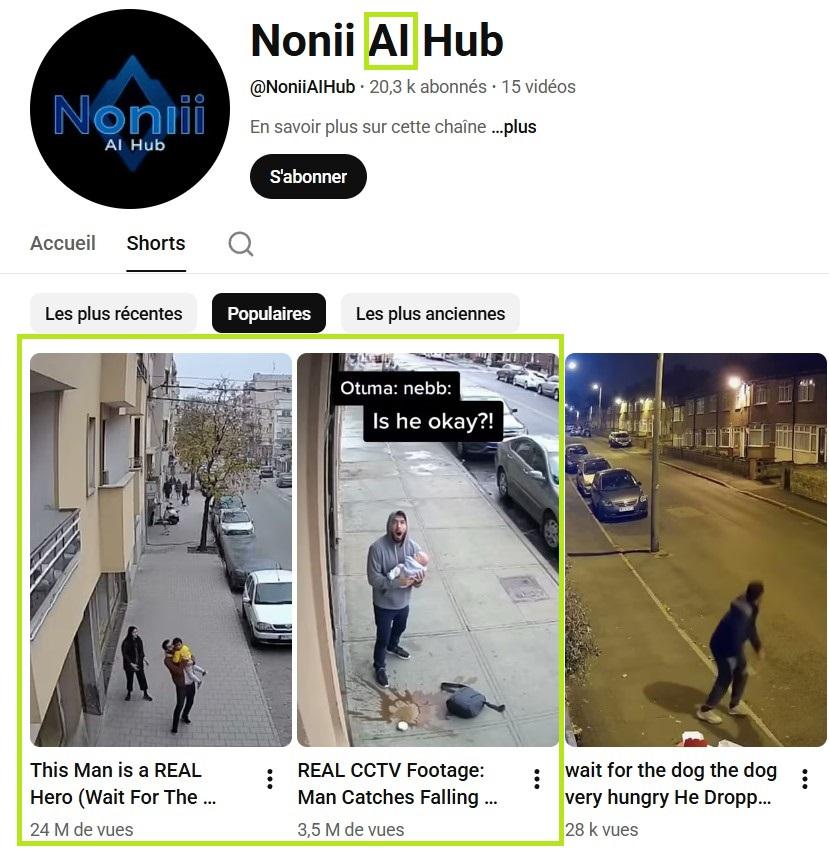

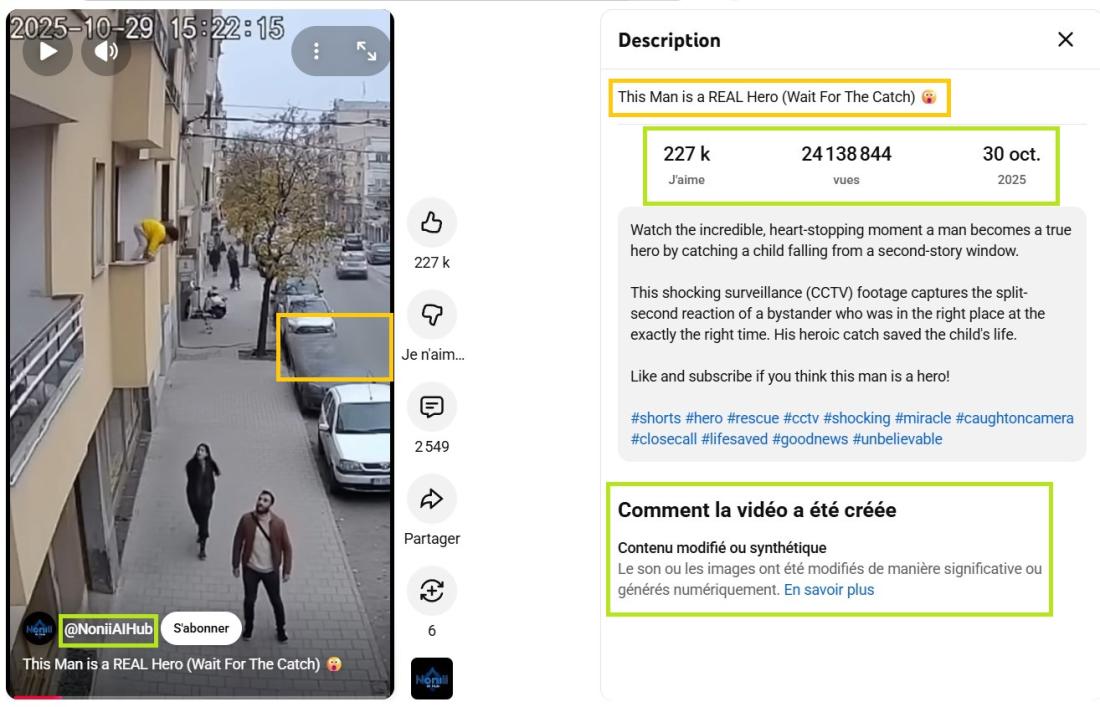

La première, montrant un homme sauvant d'une chute un enfant portant un haut jaune - également diffusée en allemand, arabe, espagnol et portugais - a été publiée le 30 octobre 2025 sur YouTube.

"Regardez ce moment incroyable et palpitant où un homme devient un véritable héros en attrapant un enfant tombant d'une fenêtre du deuxième étage. Ces images choquantes de vidéosurveillance (CCTV) capturent la réaction en une fraction de seconde d'un passant qui se trouvait au bon endroit au bon moment. Son geste héroïque a sauvé la vie de l'enfant", peut-on lire, en anglais, dans la description de la vidéo (lien archivé ici).

D'une part, le nom du compte YouTube à l'origine de la vidéo indique que son contenu est généré par IA. Entre le 26 octobre et le 4 novembre, "@NoniiAIHUb" a publié trois vidéos censées montrer des sauvetages d'enfants filmés par une caméra de surveillance. Mais toutes étaient générées par IA, comme l'indiquent leurs descriptions, et ont cumulé près de 28 millions de vues.

D'autre part, en observant les vidéos de plus près, on peut voir que deux zones dans la vidéo (au centre à droite et en bas à gauche) sont floutées et pixélisées. Cette technique est fréquemment utilisée par certains internautes diffusant des vidéos créées par Sora, une nouvelle application mobile dévoilée fin septembre par OpenAI, permettant de générer des vidéos grâce à l'IA, à partir de prompts (descriptions textuelles) (lien archivé ici). De plus, la plupart de ces séquences sont verticales et durent 15 secondes, soit la durée maximale permise par cette application.

Retrouvée elle aussi grâce à une recherche d'images inversées, la deuxième séquence, dans laquelle un homme sauve un enfant portant un bonnet bleu et un haut rose - également détournée en allemand et en anglais - avait été publiée le 15 octobre 2025 sur YouTube (lien archivé ici).

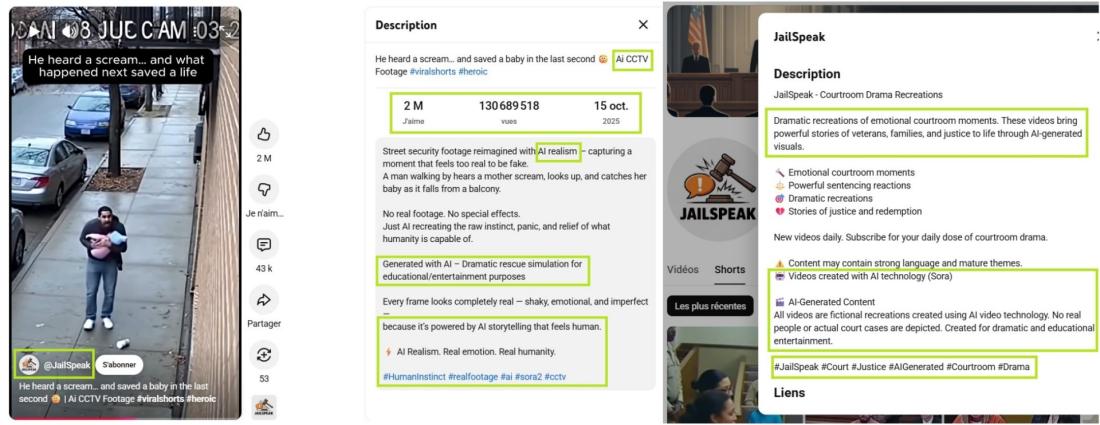

"Il a entendu un cri… et a sauvé un bébé à la dernière seconde / Vidéo de surveillance IA", peut-on lire en anglais dans la description de la vidéo, qui précise clairement qu'il ne s'agit pas de véritables images, mais d'une reconstitution générée par IA, "sans effets spéciaux", destinée à illustrer "l'instinct", la "panique" et le "soulagement" humains.

Le compte à l'origine de cette vidéo, "@JailSpeak", indique dans sa biographie qu'il publie des vidéos créées avec Sora AI : "Toutes les vidéos sont des reconstitutions fictives créées à l'aide de la technologie vidéo basée sur l'IA. Aucune personne réelle ni aucune affaire judiciaire réelle n'est représentée. Créé à des fins de divertissement dramatique et éducatif".

Ce n'est pas la première fois que des vidéos générées par intelligence artificielle sont repartagées sans contexte. En remontant à leur source, il est souvent possible de déterminer si une séquence est authentique ou générée par IA.

Copyright AFP 2017-2026. Toute réutilisation commerciale du contenu est sujet à un abonnement. Cliquez ici pour en savoir plus.